Sommario

Punti chiave

- Kafka è una potente piattaforma di streaming distribuita che può essere utilizzata per una vasta gamma di idee di progetto.

- Un'idea è quella di utilizzare Kafka per l'elaborazione e l'analisi dei dati in tempo reale, consentendo alle aziende di prendere decisioni più rapide e informate.

- Un'altra idea è utilizzare Kafka per l'origine degli eventi, che può aiutare a creare sistemi scalabili e tolleranti ai guasti.

- Kafka può anche essere utilizzato per creare pipeline di dati in tempo reale, consentendo il trasferimento continuo di dati tra sistemi diversi.

- Kafka può essere integrato con altre tecnologie come Apache Spark ed Elasticsearch per migliorare le sue capacità e fornire analisi più avanzate.

- Kafka può essere utilizzato per creare sistemi di monitoraggio in tempo reale, consentendo alle aziende di tracciare e analizzare i dati in tempo reale.

- Kafka può anche essere utilizzato per creare sistemi di messaggistica, consentendo una comunicazione efficiente tra i diversi componenti di un sistema distribuito.

- La scalabilità e la tolleranza ai guasti di Kafka lo rendono una scelta adatta per la gestione di flussi di dati ad alto volume e per garantire l'affidabilità dei dati.

- Il supporto di Kafka per la replica e il partizionamento dei dati consente un'efficiente distribuzione dei dati e bilanciamento del carico.

- Nel complesso, Kafka offre un'ampia gamma di idee progettuali e può essere uno strumento prezioso per la creazione di sistemi di elaborazione dati scalabili e in tempo reale.

Kafka Project Ideas riguarda concetti e applicazioni innovativi che coinvolgono Kafka, una piattaforma di streaming. Questi progetti possono migliorare la potenza e l'uso di Kafka per diversi settori e casi. Costruire pipeline di dati in tempo reale o progettare sistemi con tolleranza ai guasti sono alcune delle possibilità.

Un'affascinante idea di progetto è costruire un sistema di rilevamento delle anomalie basato su Kafka. Questo progetto utilizza la capacità di streaming in tempo reale di Kafka per rilevare anomalie in enormi set di dati. Questo potrebbe essere utilizzato per trovare frodi o schemi irregolari nelle transazioni finanziarie o monitorare il traffico di rete per eventuali problemi di sicurezza.

Un'altra fantastica idea di progetto è sviluppare un motore di raccomandazione basato su Kafka. Combinando Kafka con algoritmi di apprendimento automatico, è possibile creare un sistema di suggerimenti che fornisce scelte personalizzate in base alle preferenze e ai comportamenti dell'utente. Ciò può aiutare i siti di e-commerce, i servizi di streaming e le piattaforme di social media ad aumentare il coinvolgimento e la soddisfazione dei clienti.

Inoltre, i progetti relativi a Internet of Things (IoT) e Kafka possono essere entusiasmanti. Ad esempio, un sistema di monitoraggio in tempo reale che utilizza Kafka può tracciare i dati dei sensori dai dispositivi collegati. Questo potrebbe essere utile in ambienti industriali per la manutenzione predittiva o per ottimizzare l'uso delle risorse.

L'architettura guidata dagli eventi di Kafka ha il potenziale per una varietà di domini come la logistica, l'assistenza sanitaria e la finanza. È possibile utilizzare Kafka per creare sistemi di ingestione di dati scalabili o implementare pipeline di analisi in tempo reale. Secondo un sondaggio di Confluent, oltre l'80% delle aziende che utilizzano Kafka lo considera essenziale per il proprio business.

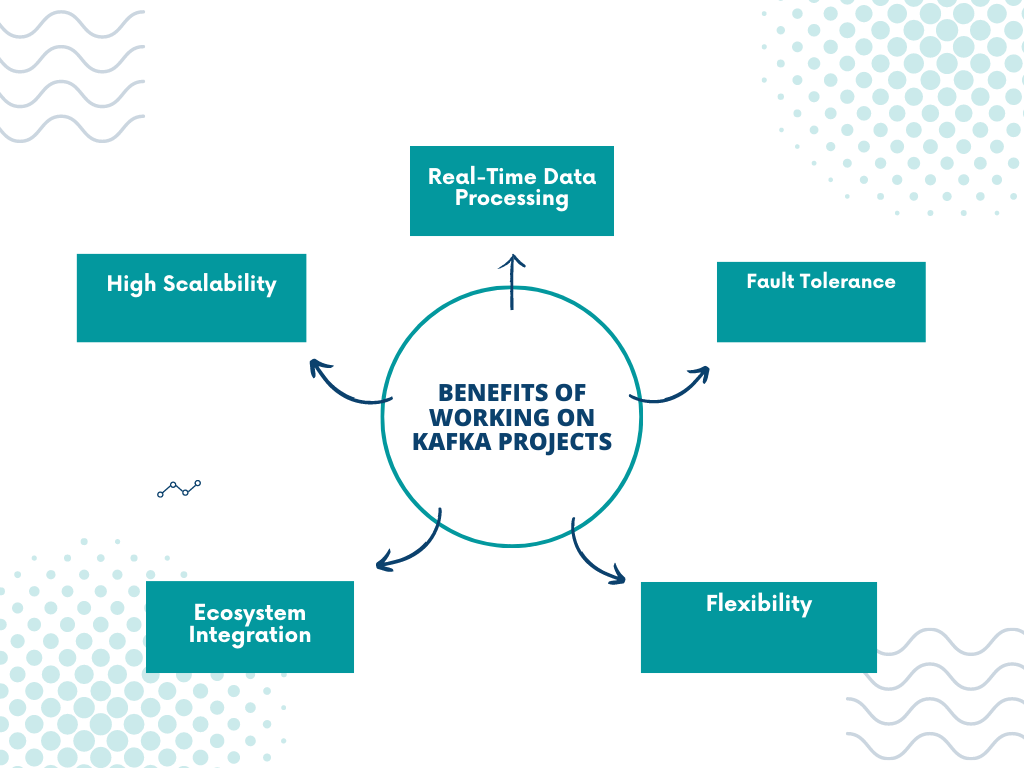

Vantaggi di lavorare su progetti Kafka

Lavorare su progetti Kafka può portare diversi benefici alla crescita di un professionista. Questi includono:

- Alta scalabilità – I dati sono distribuiti su più nodi, consentendo una gestione efficiente di enormi volumi.

- Elaborazione dati in tempo reale – La bassa latenza e l'elevato throughput forniscono streaming ed elaborazione rapidi dei dati.

- Fault Tolerance – I dati vengono replicati tra i broker, proteggendoli da eventuali guasti.

- Flessibilità – Si adatta a molti casi d'uso, come l'origine degli eventi, l'aggregazione dei log e l'elaborazione dei flussi.

- Integrazione dell'ecosistema – Si integra con Apache Spark, Hadoop ed Elasticsearch, per collegarsi alle infrastrutture di dati esistenti.

- Adozione industriale - Essendo un sistema di messaggistica standard del settore, lavorare su progetti Kafka aggiunge preziose competenze desiderate nel settore.

Kafka si distingue dagli altri per le sue caratteristiche come il supporto per cluster distribuiti e meccanismi di tolleranza agli errori integrati. Inoltre, l'esplorazione di funzionalità avanzate come l'elaborazione dei messaggi "exactly-once" e le configurazioni di sicurezza granulari ti daranno un vantaggio come esperto. Quindi, unisciti a Kafka e preparati per il surrealismo e il terrore esistenziale!

Idee per progetti Kafka

PNL semantica Variazione dell'intestazione: “Pensieri per le idee del progetto Kafka”

Ci sono numerose possibilità da esplorare quando si tratta di fare brainstorming sulle idee del progetto Kafka. Lascia che la tua creatività fluisca e considera il potenziale di questi concetti unici ed entusiasmanti.

- Integrazione del flusso di dati in tempo reale: implementare Kafka per creare un sistema affidabile ed efficiente per lo streaming e l'integrazione dei dati in tempo reale.

- Architettura dei microservizi basata sugli eventi: Utilizza Kafka per progettare e sviluppare un'architettura di microservizi basata sugli eventi, migliorando la scalabilità e la reattività.

- Pipeline di apprendimento automatico: Crea una solida pipeline di machine learning utilizzando Kafka per l'acquisizione, l'elaborazione e l'addestramento di modelli di dati senza soluzione di continuità.

- Piattaforma di analisi in tempo reale: Crea una piattaforma di analisi in tempo reale utilizzando Kafka, consentendo alle aziende di ricavare informazioni preziose dai dati in streaming.

- Gestione dei dati IoT: Sfrutta Kafka per la gestione e l'elaborazione di grandi volumi di dati generati dall'IoT, garantendo un'elaborazione e un'analisi fluide in tempo reale.

- Replica e sincronizzazione dei dati: Sviluppa un sistema di replica e sincronizzazione dei dati utilizzando Kafka per garantire la coerenza e la disponibilità dei dati su più sistemi.

Inoltre, valuta la possibilità di esplorare idee di progetti innovativi attingendo alle caratteristiche e alle capacità uniche di Kafka. Sfruttando la sua natura altamente scalabile e tollerante ai guasti, le possibilità di elaborazione dei dati in tempo reale e la perfetta integrazione con vari sistemi di dati, puoi liberare tutto il potenziale di Kafka nell'affrontare complesse sfide relative ai dati.

Per iniziare sui progetti Kafka, puoi iniziare selezionando un caso d'uso o un problema specifico che può trarre vantaggio dalle potenti funzionalità di Kafka. Sperimenta il modello Producer-Consumer di Kafka, la distribuzione dei messaggi con tolleranza ai guasti e l'architettura guidata dagli eventi. Comprendendo i punti di forza e i vantaggi di Kafka, puoi generare idee di progetto efficaci e realizzare soluzioni di grande impatto per la gestione dei dati e i requisiti di streaming del mondo reale.

Se vuoi sperimentare lo streaming di dati in tempo reale con Kafka, aspetta solo di iniziare a procrastinare su quella scadenza che hai evitato.

Streaming di dati in tempo reale con Kafka

Kafka abilita scalabilità orizzontale, garantendo che grandi volumi di dati possano essere gestiti con facilità. Ha anche incorporato replica e tolleranza ai guasti meccanismi, assicurandoti che i tuoi dati siano sempre disponibili e consegnati in modo efficace. Inoltre, il suo architettura flessibile consente una perfetta integrazione con diverse tecnologie e sistemi. Inoltre, è progettato per la velocità, il che significa che milioni di messaggi possono essere elaborati al secondo senza compromettere la latenza o il throughput.

Quando si tratta di streaming di dati in tempo reale, Kafka offre molti vantaggi. Ad esempio, un'applicazione sanitaria che raccoglie informazioni sui pazienti da più ospedali contemporaneamente può utilizzare il suo affidabile sistema di messaggistica.

C'è anche la storia di una società di logistica che ha utilizzato Kafka per lo streaming di dati in tempo reale. Stavano riscontrando problemi nel tracciare le spedizioni a causa di ritardi nella ricezione degli aggiornamenti. Ma, dopo aver implementato Kafka, sono riusciti a stabilire un canale di comunicazione affidabile tra tutte le parti interessate coinvolte e a monitorare le spedizioni in tempo reale.

Nel complesso, sfruttare Kafka per lo streaming di dati in tempo reale può portare molti vantaggi a vari settori e casi d'uso. Può promuovere l'efficienza, migliorare i processi decisionali e aiutare a sbloccare nuove opportunità. Inoltre, puoi creare sistemi distribuiti utilizzando Kafka, perché a chi non piace diffondere il caos e la confusione su più server?

Costruire sistemi distribuiti utilizzando Kafka

Kafka, un efficace sistema distribuito, è costituito da componenti come Produttori, consumatori, argomenti, broker e ZooKeeper. I produttori pubblicano i dati negli argomenti di Kafka, mentre i consumatori li recuperano. Gli argomenti sono divisi in partizioni per l'elaborazione parallela, mentre i broker archiviano e trasmettono messaggi tra produttori e consumatori. E ZooKeeper fornisce coordinamento, gestione degli errori dei nodi, manutenzione dei metadati e configurazione dei sistemi distribuiti.

Configurazione del fattore di replica garantisce la durabilità dei messaggi, l'elevata disponibilità e la tolleranza ai guasti. Un esempio reale è una grande azienda di e-commerce che sfrutta Kafka per gestire l'elaborazione degli ordini. Milioni di ordini vengono pubblicati su argomenti dai produttori e più gruppi di consumatori li elaborano in tempo reale. Ciò consente un'elaborazione parallela efficiente, con ZooKeeper che gestisce eventuali interruzioni o guasti.

Kafka e architettura dei microservizi funzionano perfettamente insieme, fornendo streaming di dati ad alta velocità e servizi scalabili e disaccoppiati.

Kafka e l'architettura dei microservizi

Kafka, Per architettura dei microservizi, ha caratteristiche chiave come scalabilità, tolleranza d'errore, approvvigionamento di eventie elaborazione in tempo reale. Inoltre, Kafka mantiene record ordinati all'interno di ogni partizione, fornendo forte consistenza per la comunicazione di servizio. Ciò lo rende ideale per le applicazioni che richiedono rigorose garanzie di ordinazione.

Punta Pro: Quando usi Kafka con i microservizi, progetta bene gli argomenti per evitare la duplicazione dei messaggi o un consumo inefficiente! Trasforma la tua vita con le incredibili analisi in tempo reale di Kafka, più veloci che mai!

Kafka per analisi in tempo reale

Principali caratteristiche e vantaggi di Kafka:

- Elevata produttività – Elabora in modo efficiente grandi volumi di dati.

- Architettura distribuita – Tolleranza ai guasti e scalabilità sono garantite.

- Streaming di dati in tempo reale – Trasmissione quasi istantanea per azioni rapide.

- Infrastruttura robusta – Flusso di dati affidabile senza alcuna perdita.

- Integrazioni flessibili – Ottenere approfondimenti da diverse fonti di dati.

Suggerimenti per l'analisi in tempo reale:

- Serializzazione dei messaggi: utilizza un formato di messaggio compatto come Avro or Buffer di protocollo per ottimizzare l'utilizzo della rete e dello storage.

- Utilizzare Kafka Connect – Plugin per una facile integrazione con sistemi esterni.

- Efficient Consumer Design – Commit offset manualmente per migliorare la tolleranza ai guasti.

Seguendo questi suggerimenti, le aziende possono ottenere informazioni in tempo reale, ridurre al minimo la latenza e prendere decisioni migliori. Quindi, allacciati le cinture e preparati a portare i tuoi dati in una corsa sfrenata con Kafka!

Kafka per applicazioni basate su eventi

Kafka è una scelta popolare per le app basate su eventi. Può gestire elevati volumi di dati e fornire elaborazione in tempo reale. Il suo streaming di eventi distribuito e scalabile lo rende perfetto per la trasmissione di dati a bassa latenza.

Il vantaggio chiave? Suo architettura tollerante ai guasti. Con la replica, Kafka archivia i dati in modo ridondante su più nodi. Pertanto, non esiste un singolo punto di errore. Ciò aumenta l'affidabilità e la resilienza contro problemi hardware o di rete.

Inoltre, lo streaming in tempo reale consente elaborazione quasi istantanea degli eventi. Questo è un must in scenari in cui il tempo è essenziale, come i sistemi di trading finanziario o l'elaborazione dei dati dei sensori.

E Kafka fornisce garanzie di durata. Memorizza tutti gli eventi su disco prima dell'elaborazione. Pertanto, non si verifica alcuna perdita di dati in caso di guasti del sistema. Inoltre, puoi ridimensionarlo facilmente aggiungendo altri broker per aumentare i carichi di lavoro.

Come iniziare con i progetti Kafka

Pronto per iniziare con il tuo progetto Kafka? Segui questi 3 semplici passaggi e sarai sulla buona strada per sbloccare la potenza dello streaming e dell'elaborazione dei dati in tempo reale.

- Configurare l'ambiente:

- Scarica e installa Kafka.

- Configura e avvia il server Kafka.

- Creare argomenti e partizioni necessari.

- Scrivi un'applicazione produttore:

- Determina l'origine e il formato dei dati.

- Usa le librerie per connetterti a Kafka.

- Implementa la logica per inviare messaggi o flussi di dati.

- Sviluppare un'applicazione consumer:

- Specifica gli argomenti da cui vuoi consumare.

- Usa le librerie per connetterti come consumatore.

- Scrivi la logica per elaborare o archiviare i messaggi.

Assicurati di considerare anche altri aspetti del tuo progetto. Crea un'architettura in grado di gestire throughput elevato e tolleranza ai guasti. Inoltre, adotta strumenti di monitoraggio per tenere traccia del throughput dei messaggi, della latenza e del ritardo del consumatore. Ciò ti aiuterà a ottimizzare le prestazioni e la scalabilità e a garantire un'integrazione perfetta nella tua infrastruttura. Quindi usa la flessibilità di Kafka e sblocca nuove intuizioni dai flussi di dati in tempo reale! Pronto a tuffarti? Abbiamo gli strumenti per trasformarti in un mago di Kafka in pochissimo tempo!

Risorse e strumenti per lo sviluppo del progetto Kafka

Benvenuti nel regno di Sviluppo del progetto Kafka! È essenziale armarsi delle risorse e degli strumenti giusti per rendere il tuo viaggio più agevole ed efficiente. Esploriamo alcune di queste risorse essenziali:

- Apache Kafka (una piattaforma di streaming di eventi distribuiti)

- Piattaforma confluente (una piattaforma completa per lo streaming di eventi)

- Flussi di Kafka (una libreria client per app in tempo reale)

- KSQL (un motore SQL in streaming)

- Registro degli schemi (un servizio per la gestione degli schemi Avro)

Inoltre, approfondisci la documentazione ufficiale e i forum supportati dalla comunità per informazioni e indicazioni. Dai un'occhiata anche a webinar, conferenze e incontri relativi a Kafka. Per rimanere aggiornato sulle ultime tendenze e sviluppi nell'ecosistema Kafka, segui blog, podcast e account di social media affidabili. Impara dagli esperti seguendo corsi e tutorial online e non dimenticare di contribuire a progetti guidati dalla comunità e chiedere assistenza a persone esperte all'interno della comunità di Kafka. Armato delle risorse e degli strumenti giusti, puoi vincere qualsiasi sfida! Ma non indugiare troppo: questa era digitale non aspetta nessuno. Ora vai avanti e sfrutta al massimo ogni opportunità che ti si presenta!

Domande frequenti

Q1: Cos'è Kafka?

A1: Kafka è una piattaforma di streaming distribuita che consente l'elaborazione e l'archiviazione di flussi di dati in tempo reale ad alto volume.

Q2: Perché dovrei considerare di lavorare su un progetto Kafka?

A2: Lavorare su un progetto Kafka ti consente di acquisire esperienza con una tecnologia potente e ampiamente utilizzata per la gestione dell'elaborazione e dell'analisi dei dati in tempo reale. Può anche migliorare le tue abilità nei sistemi distribuiti e nelle architetture guidate dagli eventi.

Q3: Quali sono alcune idee progettuali per Kafka?

A3: Alcune idee di progetto per Kafka includono la creazione di un sistema di analisi in tempo reale, lo sviluppo di una pipeline di streaming di dati, la creazione di un sistema di messaggistica distribuito, l'implementazione di elaborazione di eventi complessi, l'integrazione con framework di elaborazione dati popolari come Apache Spark o Flink e la creazione di monitoraggio e sistemi di allerta.

Q4: Come posso iniziare con un progetto Kafka?

A4: Per iniziare con un progetto Kafka, puoi iniziare comprendendo le basi di Kafka, esplorando i suoi componenti chiave come produttori, consumatori e argomenti, impostando un cluster Kafka e sperimentando semplici applicazioni di streaming di dati. Ci sono anche numerosi tutorial online, documentazione e risorse disponibili per aiutarti a immergerti più a fondo in Kafka.

Q5: Quali competenze sono richieste per lavorare su progetti Kafka?

A5: Alcune competenze necessarie per lavorare su progetti Kafka includono una profonda conoscenza dei sistemi distribuiti, competenza in un linguaggio di programmazione come Java o Scala, conoscenza dei concetti di streaming dei dati, familiarità con le architetture guidate dagli eventi ed esperienza con tecnologie come Apache Kafka, Apache ZooKeeper, e Apache Spark.

Q6: Ci sono risorse disponibili per trovare idee per progetti Kafka?

A6: Sì, ci sono diverse risorse che puoi esplorare per trovare idee per progetti Kafka. Siti web come GitHub, Kaggle e la documentazione ufficiale di Apache Kafka forniscono esempi e idee di progetto. Inoltre, le community e i forum di sviluppatori online sono luoghi ideali per entrare in contatto con altri appassionati di Kafka e raccogliere ispirazione per i tuoi progetti.

Le idee progettuali Kafka e Vapt sono intercambiabili per lo sviluppo delle competenze?

Quando si tratta di sviluppo delle competenze, avere 10 idee progettuali strabilianti per Vapt è fondamentale. Sebbene le idee progettuali di Kafka e Vapt possano avere alcuni elementi sovrapposti, non sono del tutto intercambiabili. Kafka si concentra sull'elaborazione del flusso in tempo reale, mentre i progetti Vapt riguardano maggiormente la valutazione delle vulnerabilità e i test di penetrazione.

Conclusione

Esplorare i progetti di Kafka è stato un viaggio straordinario, mettendo in evidenza il potenziale illimitato di questa straordinaria tecnologia. In questo articolo, ci siamo tuffati nei diversi aspetti e opportunità offerte da Kafka. Abbiamo parlato di elaborazione dei dati in tempo reale e architetture guidate dagli eventi e ha persino esplorato il modo in cui Kafka consente una comunicazione senza soluzione di continuità tra sistemi diversi e il suo potere di semplificare flussi di lavoro di dati complessi.

La nostra esplorazione delle potenzialità di Kafka non è finita qui. Prima di concludere, è fondamentale sottolineare la necessità di continua sperimentazione e perfezionamento quando si implementa Kafka nelle organizzazioni. Con ogni sfida arriva la possibilità di miglioramento e con l'iterazione persistente, possiamo sbloccare ulteriori progressi utilizzando le capacità di Kafka.

L'origine di Kafka è stata quella di creare a sistema di messaggistica altamente scalabile in grado di gestire enormi quantità di flussi di dati in tempo reale. È iniziato su LinkedIn quando è nata la necessità di un sistema di messaggistica distribuito in grado di gestire il quantità sempre crescente di dati prodotti dalle interazioni degli utenti sul loro sito web. Apache Kafka è nato e molto presto ha guadagnato popolarità grazie al suo progettazione tollerante ai guasti ed efficacia nell'affrontare flussi di dati ad alto rendimento.

Riferimenti

Idee di progetto Kafka per principianti

Leggi anche:

- Idee progettuali sullo zootropio

- Idee per app iOS

- Temi del progetto Mca

- Idee progettuali Cas

- Idee progettuali Sfml

- Idee per progetti NFC

- Argomenti del progetto di inglese per la classe 6

- Idee di progetto per i servizi di integrazione del server SQL

- Idee per progetti di apprendimento automatico

- Argomenti del progetto finanziario

Ciao…..sono Rivin George, un individuo appassionato a cui piace sperimentare infinite possibilità chimiche. Ho completato la mia specializzazione in chimica applicata. Avendo una migliore comprensione dell'argomento, vorrei creare concetti di chimica interessanti e aggiornati e fornirli nel modo più semplificato. Colleghiamoci tramite LinkedIn: